公司研究论文“发散增强的知识引导提示优化”(“Divergence-Enhanced Knowledge-Guided Context Optimization for Prompt Tuning”)被机器学习领域国际顶级会议ICLR 2025录用,员工作者为硕士研究生李逸伦,指导教师为程苗苗老师和宋巍教授。

ICLR全称为国际表征学习会议(International Conference on Learning Representations),是全球机器学习领域最具影响力的学术会议之一,与国际机器学习大会(ICML)、神经信息处理系统大会(NeurIPS)并称为“机器学习三大顶会”。

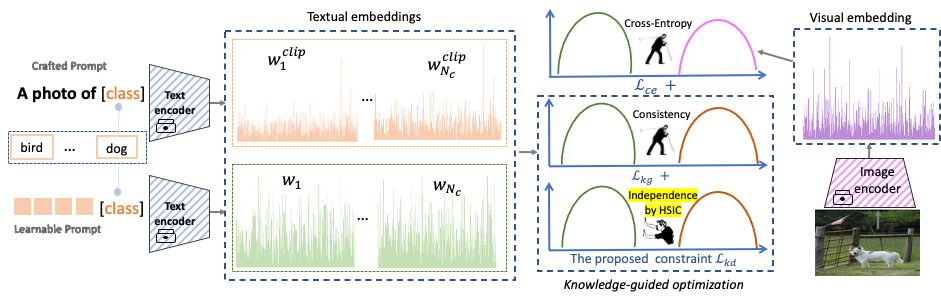

文章主要探讨视觉语言多模态大模型的低资源迁移学习问题。提示微调(Prompt Tuning)尽管可有效地将预训练视觉-语言模型适应于各种少样本和零样本视觉识别任务,但在有限的训练样本下极易过拟合于可见类别,导致预训练模型的知识遗忘。为缓解此问题,本文提出一种新颖而简单的发散增强的知识引导提示优化方法,通过引入希尔伯特-施密特独立准则(Hilbert-Schmidt Independence Criterion, HSIC),设计有效的正则化约束,协同增强可学习提示与知识引导自然语言提示的一致性与独立性。该方法即插即用,可与任意知识引导提示微调方法无缝集成,并在新类别泛化、跨数据集泛化、少样本学习三个具有挑战性的图像分类基准测试集上显示了优秀性能。该研究由国家自然科学基金青年与面上项目资助。